发布时间:2025-04-29 08: 00: 00

在团队协作日益频繁、CI/CD流水线任务持续增长的背景下,GitLab数据库的负载压力也随之上升。当你发现 GitLab 页面加载变慢、Merge Request 无响应、CI 查询卡顿时,其根本原因往往集中在 数据库响应迟缓或资源瓶颈上。由于 GitLab 采用 PostgreSQL 作为核心数据库,若出现性能问题,不仅会影响代码托管和用户体验,还可能造成部署失败或数据写入延迟。本文将围绕“GitLab查询数据库卡顿是什么原因 GitLab如何优化数据库性能”两个核心问题,深入剖析常见的性能瓶颈,并提供实用的优化方法。

一、GitLab查询数据库卡顿是什么原因

GitLab 使用 PostgreSQL 存储几乎所有关键数据(项目、用户、CI、MR、评论、权限等),因此数据库性能瓶颈会直接影响整体使用流畅度。以下是导致 GitLab 数据库查询卡顿的主要原因:

1. 大量无索引或低效SQL查询

某些页面加载时会发出包含 JOIN 或 FILTER 的复杂 SQL;

若表中数据量很大,而相关字段未建立索引,则 PostgreSQL 只能全表扫描;

比如:查询 Merge Request 的审批人列表、CI作业的执行记录等。

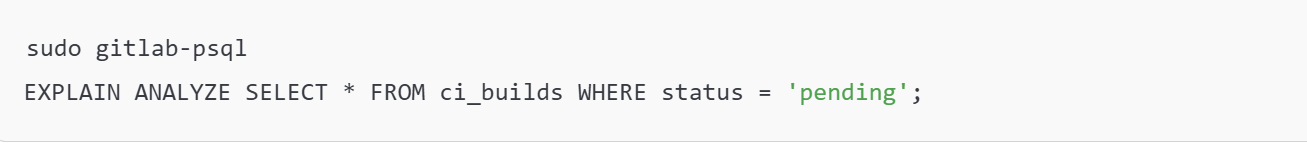

诊断方式:

如果发现“Seq Scan”且执行时间较长,说明缺失索引。

2. 表数据膨胀严重

PostgreSQL 虽然支持 MVCC(多版本并发控制),但删除或更新后的行仍会残留在磁盘中;

长期运行后表膨胀严重,查询效率下降;

如:ci_builds、audit_events、merge_requests 等高频写表。

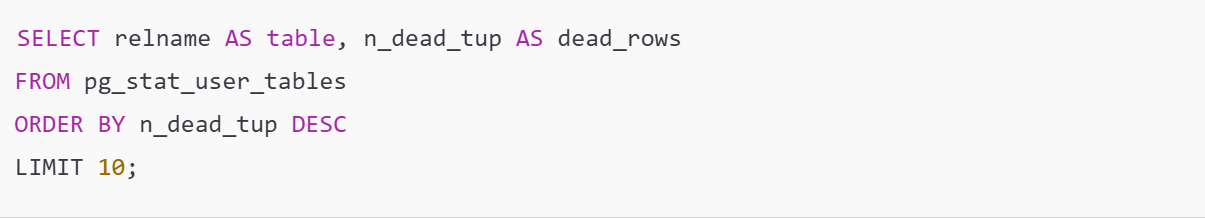

诊断方式:

死元组(dead_rows)数量过高会拖慢查询性能。

3. 并发连接过多,连接池饱和

默认 PostgreSQL 最大连接数有限(如100);

当多个Runner、大量用户同时发起请求时,连接数迅速达到上限;

超出连接池时,新的请求将被挂起或拒绝。

诊断方式:

SELECT count(*) FROM pg_stat_activity;

连接数过高时需优化连接池或增加并发能力。

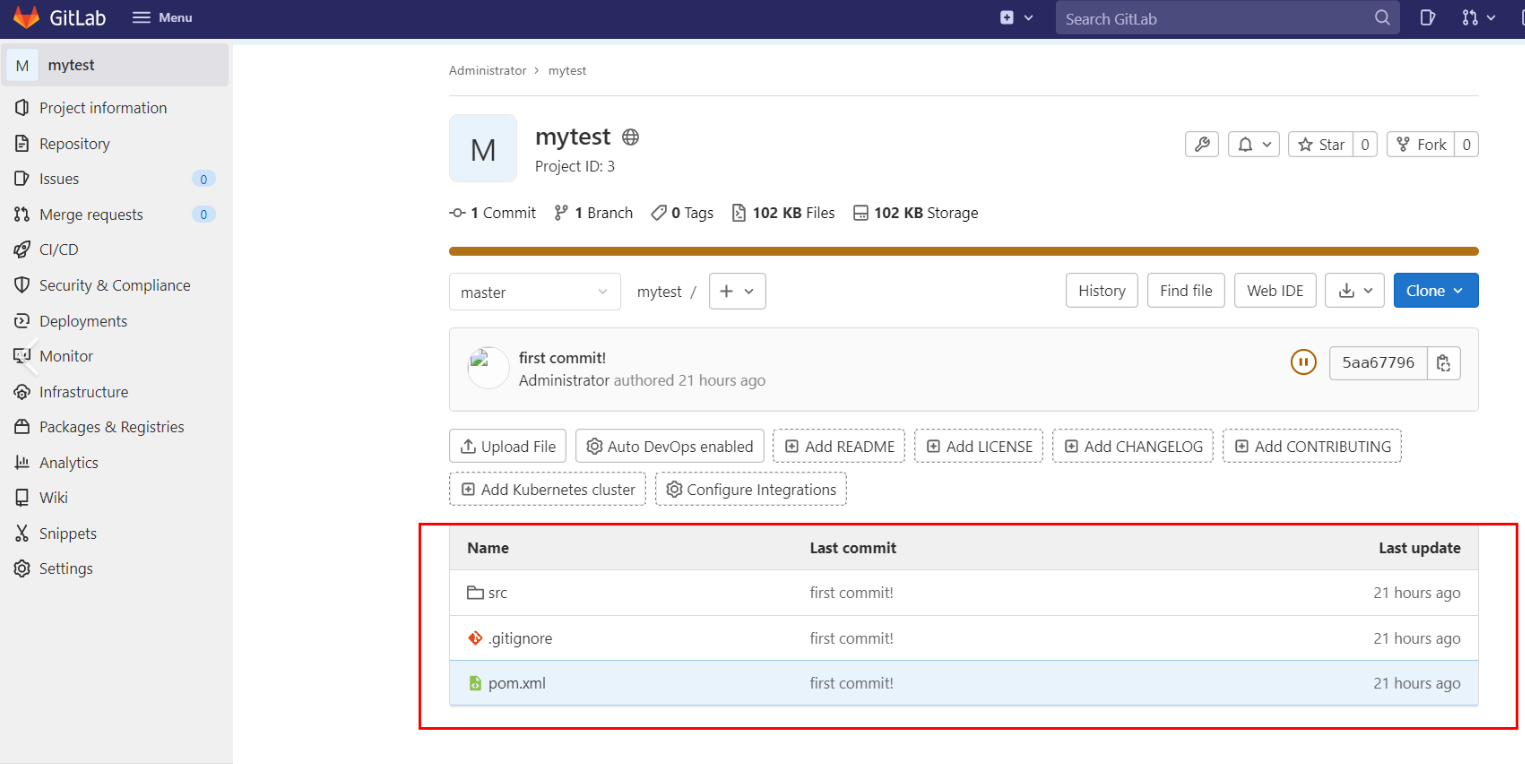

4. CI/CD作业表增长迅速

ci_builds、ci_jobs、ci_pipeline 等表会随着每次CI执行增长;

若未配置 artifacts 清理策略或 Pipeline 生命周期,几个月内可积累数百万条数据;

导致查看项目流水线历史、点击Pipeline详情卡顿明显。

5. 数据库硬件I/O瓶颈

磁盘读写延迟高、内存缓存不足会直接拖慢查询;

常见于部署在虚拟机或共享存储的GitLab实例上。

诊断方式:

iostat -x 1

观察 PostgreSQL 数据目录所在磁盘的 await 和 %util。

二、GitLab如何优化数据库性能

GitLab 官方已提供多种手段支持数据库性能优化,结合实际部署环境,你可以从索引优化、清理策略、表结构调整、配置调优、读写分离等多个层面进行优化。

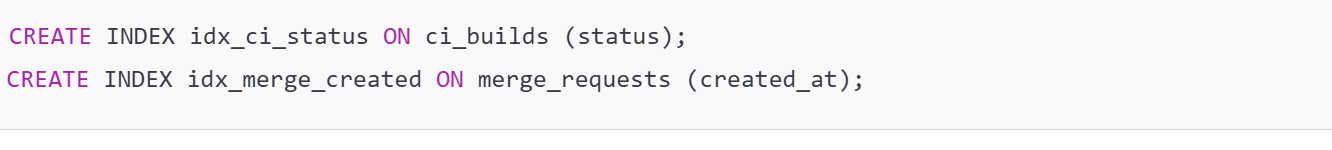

1. 添加必要的索引

针对查询慢的表,手动添加索引是最直接有效的方法。

示例:

添加索引后再执行 ANALYZE 让 PostgreSQL 更新统计信息:

ANALYZE ci_builds;

建议先在测试环境评估查询速度变化,再部署至生产环境。

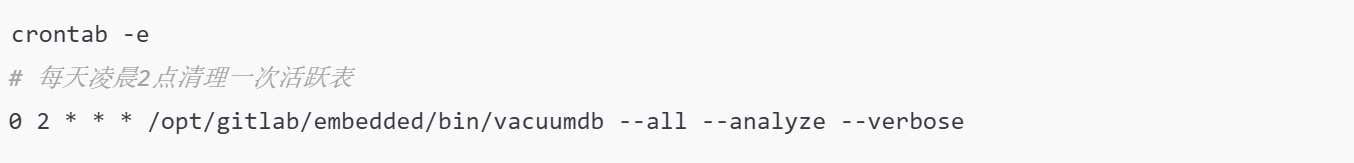

2. 定期执行 VACUUM 清理死元组

手动触发:

也可以配置自动任务(或系统计划任务):

对膨胀严重表建议执行 VACUUM FULL(期间会锁表,需避开高峰)

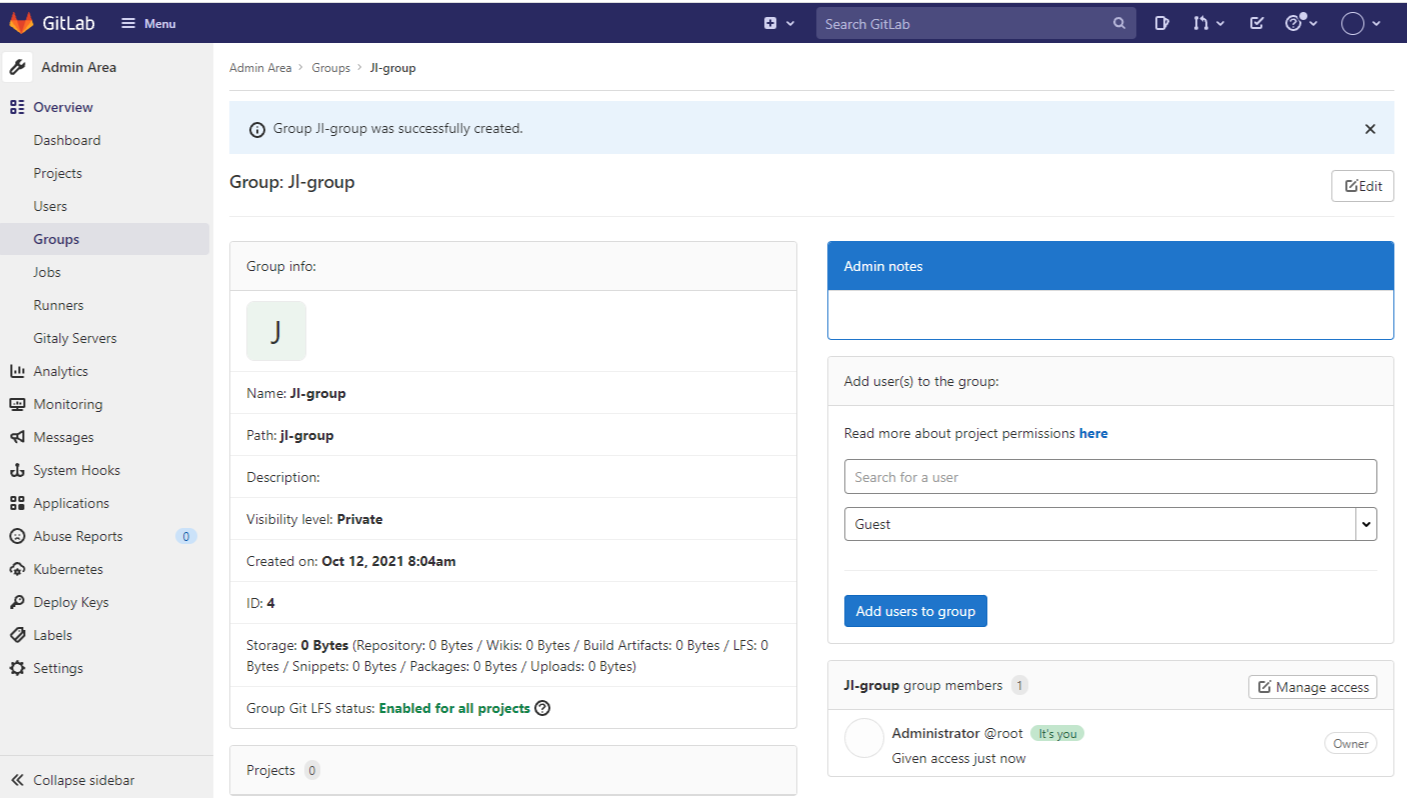

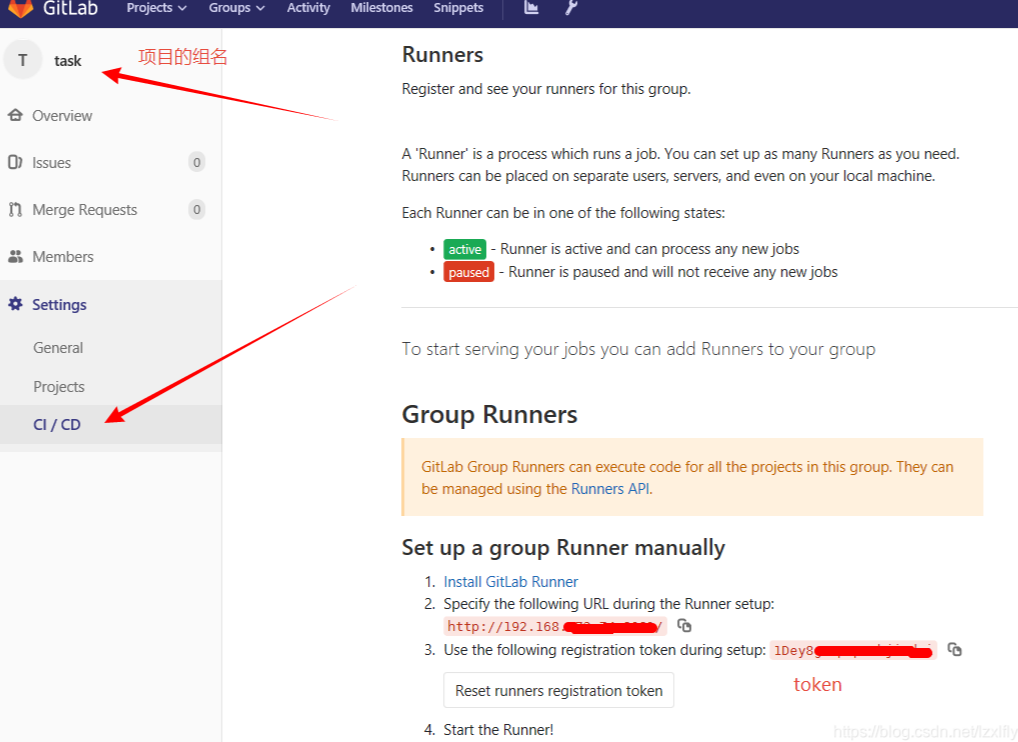

3. 清理历史CI数据、Pipeline 和 Artifacts

通过 GitLab 提供的清理任务释放表空间:

gitlab-rake gitlab:cleanup:orphan_job_artifacts

项目层面设置 artifacts 生命周期:

项目 → Settings → CI/CD → General Pipelines;

配置“Artifacts expire after”时间,例如 7 days。

也可以通过 API 删除无效 pipeline:

DELETE /projects/:id/pipelines/:pipeline_id

4. 启用连接池与负载均衡机制

若并发连接数过多,可使用连接池工具如 PgBouncer:

作为 PostgreSQL 前置代理,复用连接;

降低 GitLab 与数据库之间的连接压力;

适合高并发 Runner 场景。

GitLab 高可用部署推荐使用:

gitlab-ctl pgbouncer-setup

5. 配置 PostgreSQL 性能参数

可在 /var/opt/gitlab/postgresql/data/postgresql.conf 调整如下参数:

具体参数值应根据内存大小与负载调整。

调整后重启 PostgreSQL:

gitlab-ctl restart postgresql

6. 配置读写分离结构(主从架构)

主库负责写入;

从库配置只读查询,如审计、数据可视化等;

使用外部工具如 Patroni、pgpool、Stolon 实现自动切换。

三、监控与持续性能优化策略

为了更长效维护数据库性能,建议引入以下策略:

1. 使用 GitLab 内置诊断工具

gitlab-rake gitlab:db:diagnose

可分析慢查询、失效索引、膨胀表结构等问题。

2. 使用pg_stat_statements追踪慢查询

在 postgresql.conf 中启用插件:

shared_preload_libraries = 'pg_stat_statements'

查看耗时前十的SQL:

3. 监控 PostgreSQL 指标

结合 Prometheus + Grafana 实现以下监控:

数据库连接数

磁盘使用

缓存命中率

活跃查询数

死锁与失败事务

GitLab 可通过内置 Prometheus exporter 提供数据源。

总结

本文围绕“GitLab查询数据库卡顿是什么原因 GitLab如何优化数据库性能”两个核心问题,系统分析了 GitLab 使用 PostgreSQL 过程中的常见性能瓶颈,如索引缺失、表膨胀、连接饱和、历史数据堆积等问题,并提供了从结构优化到系统配置、自动清理到连接池调优的多层级解决方案。对于运行中的中大型GitLab实例,保持数据库高效稳定是保障DevOps流程顺畅的关键,建议将“索引管理 + 数据清理 + 连接优化 + 监控报警”作为标准运维体系的一部分,持续优化平台性能。

展开阅读全文

︾

读者也喜欢这些内容:

GitLab如何备份重要代码 GitLab的仓库自动备份如何配置

在软件开发过程中,代码是企业的重要资产,我们需要严格保障代码安全,因此很多公司选择自己搭建GitLab服务作为代码托管平台,一旦发生危险情况,例如员工误删、服务器宕机、硬件损坏等情况,使用备份文件可以及时恢复代码,避免损失,所以GitLab的数据就需要及时备份。本文将为大家介绍GitLab如何备份重要代码,GitLab的仓库自动备份如何配置的相关内容。...

阅读全文 >

Gitlab的Merge Request合并冲突怎么解决 Gitlab如何简化合并流程

在团队协作开发时,代码合并是每个程序员工作中会遇到的操作,所以我们需要掌握合并流程,并且知道发生冲突该怎么解决。Gitlab平台是很多公司正在使用的代码托管平台,该平台支持Merge Request(合并请求),并且为代码审查与合并提供了标准化流程。当多人并行开发时,就很可能出现合并冲突的情况,如何高效解决冲突并优化合并流程呢?本文将为大家介绍Gitlab的Merge Request合并冲突怎么解决,Gitlab如何简化合并流程的相关内容。...

阅读全文 >

GitLab如何追踪代码修改记录 GitLab中如何查看文件变更历史

在日常开发中,管理代码变更真的挺重要,特别是在团队协作中,如果不清楚谁改了什么,出了问题很难追溯。而GitLab作为一款流行的代码管理平台,追踪代码修改记录和查看文件变更历史这两个功能特别实用。那么,GitLab如何追踪代码修改记录 GitLab中如何查看文件变更历史?今天我们就来聊聊这个话题。...

阅读全文 >

GitLab怎么实现数据库的高可用性 GitLab如何搭建高可用服务器

随着企业开发流程向自动化、规模化不断推进,GitLab 不再只是代码仓库,更是集代码审查、持续集成、部署与权限管理于一体的 DevOps 中心平台。与此同时,系统的稳定性也成为团队效率的底线。尤其是 GitLab 的数据库(PostgreSQL),一旦发生故障,整个系统将陷入瘫痪。为了避免单点故障导致服务中断,GitLab 提供了多种方式实现 数据库高可用(High Availability, HA)。本文围绕“GitLab怎么实现数据库的高可用性 GitLab如何搭建高可用服务器”两个问题,从架构选型到部署实操,全面讲解 GitLab 的高可用建设路径,帮助企业构建稳固、高性能的协作平台。...

阅读全文 >